Распространенные заблуждения

Вопреки

распространенному мнению, «пауки» не обрабатывают полученную информацию.

Программа только сканирует и сохраняет веб-страницы, а дальнейшей

обработкой занимаются совершенно другие роботы.

Также многие

пользователи считают, что поисковые роботы оказывают негативное

воздействие и «вредны» интернету. Действительно, отдельные версии

«пауков» могут значительно перегружать сервера. Имеет место и

человеческий фактор – веб-мастер, который создавал программу, может

допускать ошибки в настройках робота. Все же большинство действующих

программ хорошо спроектированы и профессионально управляются, а любые

возникающие неполадки оперативно устраняются.

Разновидности поисковых роботов

Различают множество разновидностей поисковых роботов. В зависимости от назначения программы они бывают:

- «Зеркальными» — просматривают дубликаты сайтов.

- Мобильными – нацелены на мобильные версии интернет-страниц.

- Быстродействующими – фиксируют новую информацию оперативно, просматривая последние обновления.

- Ссылочными – индексируют ссылки, подсчитывают их количество.

- Индексаторами различных типов контента – отдельных программ для текста, аудио- и видеозаписей, изображений.

- «Шпионскими» — ищут страницы, которые еще не отображаются в поисковой системе.

- «Дятлами» — периодически посещают сайты, чтобы проверить их актуальность и работоспособность.

- Национальными – просматривают веб-ресурсы, расположенные на доменах одной страны (например, .ru, .kz или .ua).

- Глобальными – индексируют все национальные сайты.

Программы-аналоги поисковых роботов

Часто понятие «поисковый робот» путают с интеллектуальными, пользовательскими или автономными агентами, «муравьями» или «червями». Значительные отличия имееются только по сравнению с агентами, другие определения обозначают схожие виды роботов.

Так, агенты могут быть:

- интеллектуальными: программы, которые перемещаются от сайта к сайту, самостоятельно решая, как поступать дальше; они мало распространены в интернете;

- автономными: такие агенты помогают пользователю в выборе продукта, поиске или заполнении форм, это так называемые фильтры, которые мало относятся к сетевым программам.;

- пользовательскими: программы способствуют взаимодействию пользователя со Всемирной паутиной, это браузеры (например, Opera, IE, Google Chrome, Firefox), мессенджеры (Viber, Telegram) или почтовые программы (MS Outlook или Qualcomm).

«Муравьи» и «черви» больше схожи с поисковыми «пауками». Первые образуют между собой сеть и слаженно взаимодействуют подобно настоящей муравьиной колонии, «черви» же способны самовоспроизводиться, в остальном действуют так же, как и стандартный поисковый робот.

Написание и проверка robots.txt

Теперь вы знаете, какими директивами и как пользоваться. Переходите к написанию файла:

- Откройте текстовый редактор, к примеру, Блокнот.

- Пропишите содержимое.

- Сохраните документ с именем robots в формате txt.

- Опубликуйте файл в корневой каталог.

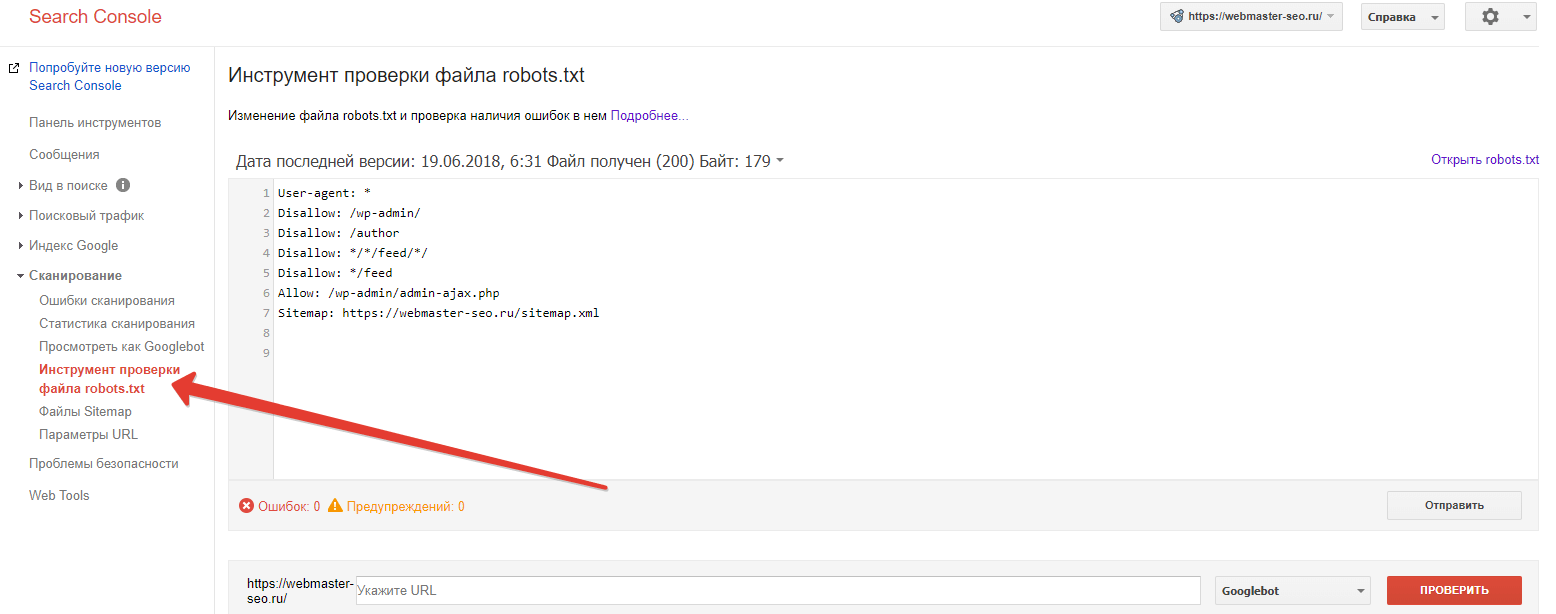

Не загружайте готовый robots.txt сразу на веб-сайт. Сначала сделайте его проверку одним из методов:

- В Google Search Console. Для этого нужно открыть «Сканирование» – «Инструмент проверки файла robots.txt». Потом вставляем содержимое robots.txt в указанное поле и задаём адрес веб-сайта. Кликаем «Проверить».

Google автоматически укажет вам на имеющиеся ошибки и покажет предупреждения. При наличии таковых нужно внести корректировки. Кроме того, пользуясь инструментами системы, вы можете получать уведомления о появившихся ошибках – они будут доступны в админке Console.

- В Яндекс.Вебмастер. Откройте «Инструменты» – «Анализ robots.txt». Всё происходит аналогично предыдущему способу – вводим адрес веб-сайта, копируем и вставляем содержимое написанного файла. Кликаем «Проверить» и получаем результаты – ошибки и предупреждения.

Как функционируют роботы поисковых систем

Поисковый робот (паук, бот) представляет собой небольшую программу, способную без участия оператора посещать миллионы web-сайтов и сканировать гигабайты текстов. Считывание страниц и сохранение их текстовых копий – это первая стадия индексации новых документов. Следует отметить, что роботы поисковых систем не осуществляют какую-либо обработку полученных данных. В их задачу входит только сохранение текстовой информации.

Больше видео на нашем канале — изучайте интернет-маркетинг с SEMANTICA

Так же, в логах своего сайта, вы можете наткнуться на некоторых роботов других поисковиков.

Как работают поисковые роботы

Каждая

поисковая система имеет собственного бота, при этом поисковый робот

Google может значительно отличаться по механизму работы от аналогичной

программы «Яндекса» или других систем.

В

общих чертах принцип работы робота заключается в следующем: программа

«приходит» на сайт по внешним ссылкам и, начиная с главной страницы,

«читает» веб-ресурс (в том числе просматривая те служебные данные,

которые не видит пользователь). Бот может как перемещаться между

страницами одного сайта, так и переходить на другие.

Как программа

выбирает, какой сайт индексировать? Чаще всего «путешествие» паука

начинается с новостных сайтов или крупных ресурсов, каталогов и

агрегаторов с большой ссылочной массой. Поисковый робот непрерывно

сканирует страницы одну за другой, на скорость и последовательность

индексации влияют следующие факторы:

-

внутренние:

перелиновка (внутренние ссылки между страницами одного и того же

ресурса), размер сайта, правильность кода, удобство для пользователей и

так далее; - внешние: общий объем ссылочной массы, которая ведет на сайт.

Первым

делом поисковый робот ищет на любом сайте файл robots.txt. Дальнейшая

индексация ресурса проводится, основываясь на информации, полученной

именно от этого документа. Файл содержит точные инструкции для «пауков»,

что позволяет повысить шансы посещения страницы поисковыми роботами, а

следовательно, и добиться скорейшего попадания сайта в выдачу «Яндекса»

или Google.

Устройство поисковых машин

Поисковая система – это система, программно-аппаратный комплекс которой предназначен для поиска информации. Условно такие системы можно разделить на четыре больших класса:

-

Системы, использующие поисковых роботов;

-

Системы, управляемые человеком;

-

Гибридные системы;

-

Мета-системы.

В повседневном использовании Интернета пользователь часто сталкивается с системами на поисковых роботах таких компаний, как Google, Bing и Yandex. Данные продукты также называют поисковыми машинами.

Устройство поисковых машин можно рассматривать следующим образом:

-

Spider (паук или спайдер) – программа, скачивающая страницы из Интернета для последующего анализа и запоминания в базу данных.

-

Crawler (краулер, паук-путешественник) – программа, которая ищет полезные ссылки на странице ресурса и осуществляет переход по ним. Логика обхода страниц определяется алгоритмами информационного поиска.

-

Indexer (индексатор) – компонент, осуществляющий вычленение полезной информации со страницы и сохраняющий полученный результат в структурированном виде в базу данных поисковой машины.

-

Database (база данных) – огромный каталог обработанных системой страниц сайтов, использующийся для поиска информации на проиндексированных сайтах.

-

Search engine results (система выдачи результатов) – система, предназначенная для извлечения необходимых данных из каталога по запросу пользователя.

-

Web server (веб-сервер) – веб-сервер, связывающий конечного пользователя с поисковой системой.

Под поисковым роботом, пауком или агентом принято понимать комплекс, состоящий из паука, краулера и индексатора.

Поисковый агенты пишутся на языках высокого уровня. Это позволяет им эмулировать поведение обычных браузеров или решать специализированные задачи: использование сетевого протокола передачи новостей NNTP, получение электронной почты по SMTP или чтение лент новостей из RSS.

В поисковых системах Яндекс и Google можно выделить похожие по функциям роботов:

-

Робот-индексатор:

-

Страниц для web-браузера десктопа.

-

Страниц для web-браузера смартфона.

Робот по изображениям.

Робот по видео.

Робот по новостям.

Робот-индексатор занимается обнаружением и индексацией страницы. Под индексированием понимается процесс извлечения данных из веб-страницы, с последующим извлечением в специальную базу поисковика.

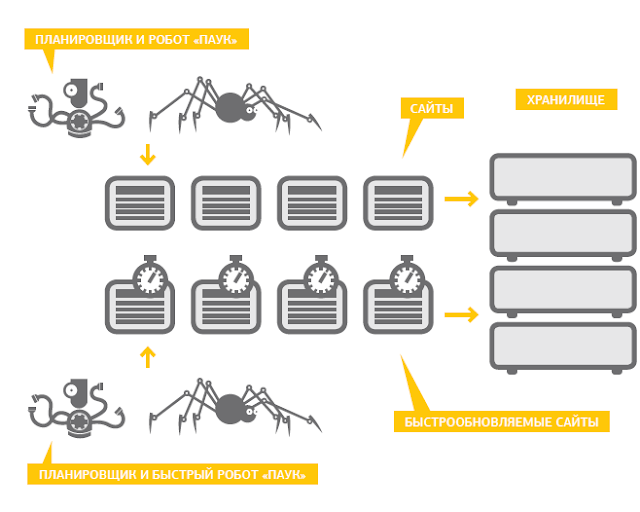

Робот-индексаторы бывают основными и быстрыми. Основной робот занимается индексированием нового контента, быстрый – обновляет индекс часто меняющихся страниц.

|

| Поисковый паук в поисковых системах |

Планировщик занимается составлением маршрута обхода сайтов роботами. При первом посещении страницы поисковым роботом происходит проверка на соответствие контента правилам поисковой системы, при последующих обходах – происходит занесение свежей информации. Разработчики сайтов управляют областью индексирования их ресурсов с помощью файлов robots.txt или sitemap.xml. Также на самих веб-страницах для оптимизации процесса индексирования используются мета-теги, теги и атрибуты noindex и nofollow.

На данный момент поисковые роботы умеют индексировать не только веб-страницы, но и офисные документы, например, файлы, созданные в пакетах MS Office и Open Office, документы формата PDF, RTF и TXT.

Робот по изображениям заносит в индекс графическую информацию. Сервисы «Яндекс.Картинки» и «Google Картинки» предоставляют возможность поиска изображения по заданному образцу.

Робот по видео индексирует видеоролики.

Робот по новостям занимается добычей статей с новостных ресурсов. Далее эти статьи в агрегированном виде предоставляются пользователю в виде ленты новостей.

Поисковые системы могут иметь и другие виды роботов, перед которыми ставят свои особые задачи. Например, у Яндекса имеется робот, проверяющий работоспособность сайта или страницы.

Виды роботов

Общепринятой классификации роботов не существует. Основные характеристики, по которым можно условно поделить все модели – назначение и внешний интерфейс.

По внешнему интерфейсу роботы делятся на:

Андроиды

Андроиды внешне абсолютно идентичны человеку, поэтому имеют второе название «синтетический человек». Они способны поддерживать разговор, используя большой словарный запас, а их поведение зависит от факторов внешней среды и логично изменяется. Сфера обслуживания теоретически может перейти на использование андроидов вместо многих сотрудников.

(Робот андроид)

Роботы, подобные животным

Применяются в качестве игрушек или в целях слежки за дикими животными в их естественных условиях обитания. Уже изобретены электронные зооморфы внешне идентичные гикконам, белкам, собакам, медузам, червям, гепардам и т.д.

(Робот собака)

Гуманоидные роботы

Внешне они отдалённо напоминают человека. В основном их корпус состоит из подобия головы, рук, ног и туловища. Но эти элементы более схожи с частями машины, нежели человека. Гуманоиды обычно имеют узкую направленность действий, например раздача рекламных листовок, определённая игра с детьми.

(Робот компаньон)

- По выполняемым функциям выделяют:

Бытовые роботы

Ежедневное применение в быту отличает эту группу роботов от других. Помимо всеобще известных роботов-пылесосов и мойщиков окон, к этому классу относятся робоигрушки для детей и средства-коммуникаторы, создающие эффект присутствия человека, находящегося на большом расстоянии (передающие его сердцебиение или частоту дыхания).

(Робот-пылесос)

Промышленные роботы

Замена человеческого труда на производстве роботизированным механизмом широко распространена по ряду причин. Качество выпускаемой продукции возрастает за счёт исключения ошибок, связанных с «человеческим фактором». Работоспособность 24 часа в сутки, 7 дней в неделю повышает производительность предприятия минимум дважды. Никакие вредные испарения или излучения не становятся помехой в работе.

(Робот для захвата предметов)

Операции, выполняемые промышленными роботами: штамповка, сварка, фрезеровка, транспортировка грузов, сборка, обработка, окрашивание и т.д.

Боевые роботы

Минимизация человеческих потерь в военных действиях достигается посредствам введения в вооруженные силы роботов. Для каждого рода войск разработаны определённые модели: роботы-сапёры, беспилотники, подводные и надводные корабли с дистанционным управлением, вертолёты-разведчики, роботы-минёры и т.п.

(Военный робот)

Из-за неоднозначности мнений по поводу ответственности за действия роботов их применение в реальных условиях ограничено.

Микророботы

Отличительной особенностью этого вида является сверхмалый размер – до 1мм. Чаще всего работа таких устройств связана с групповым взаимодействием (например, для быстрого построения сверхпрочной и лёгкой материи) или с объектами, площадь которых исчисляется микрометрами.

(Микроустройство размером с частицу — Наноробот)

Рассматриваются перспективы применения микроустройств — нанороботов в медицинских целях (для проникновения в организм с последующей диагностикой).

Персональные роботы

Персональные роботы предназначены для сопровождения определённого человека, выполнения его просьб, общения с ним. Из-за недостаточной совершенности ПО идеальный компаньон для человека ещё не создан. Разработчики предполагают, что он будет иметь чувствительные датчики для распознавания не только звуковых сигналов, но и мимики, жестов, манеры поведения объекта. Запоминание характерных черт поведения и самосовершенствование позволят добиться взаимопонимания между роботом и пользователем.

(Персональный робот будущего)

Специализированные роботы

Технические роботы определенных специальностей с узкой спецификой и олее широким применением определенных отраслей:

- Транспортные — основные направления деятельности транспортных роботов – это автономное управление средствами передвижения (автопилотирование, самоходные автомобили) и перемещение грузов.

- Исследовательские — используются для сбора данных из труднодоступных для человека областей, для направления их на изучение специалистам. При этом объекты исследования могут быть самыми разнообразными: от подземного пространства до поверхности планет.

- Сельскохозяйственные — применяются в основном для выполнения монотонных и трудных операций, таких как вспахивание земли, высадка, прополка, обработка удобрениями больших площадей и т.д.

- …и других специализированных областей.

Краткая история роботизации

За последние 100 лет роботы не просто эволюционировали, они стали частью нашей повседневной жизни. Слово «робот» вошло в обиход после того, как в 1920 году свет увидела пьеса Карла Чапека об искусственных людях. И это очень символично, так как «ревущие» двадцатые — период экономического подъема и новых открытий в науке и технике.

В течение последующих десятилетий произошли выдающиеся открытия в самых различных дисциплинах — кибернетика, мехатроника, информатика, электроника, механика, а именно на них и опирается робототехника. Примерно к 30-м годам XX века появились первые андроиды, которые могли двигаться и произносить простейшие фразы.

Первые программируемые механизмы с манипуляторами были сконструированы в 1930-х годах в США. Толчком послужили работы Генри Форда по созданию автоматизированной производственной линии. На рубеже 1930-40-х годов в СССР появились автоматические линии для обработки деталей подшипников, а в конце 1940-х годов было впервые в мире создано комплексное производство поршней для тракторных двигателей с автоматизацией всех процессов — от загрузки сырья до упаковки готовой продукции.

В 1950 году Тьюринг в работе «Computing Machinery and Intelligence» описал способ, позволяющий определить, является ли машина мыслящей (тест Тьюринга). В 1950-х годах появились первые механические манипуляторы, которые копировали движения рук оператора и могли работать с радиоактивными материалами. В 1956 году американские инженеры Джозеф Девол и Джозеф Энгельберг организовали первую в мире компанию «Юнимейшн» (англ. Unimation, сокращенный термин от Universal Automation, универсальная автоматика), и в начале 1960-х первый в мире промышленный робот начал работать на производственной линии завода General Motors.

Робот Unimate, которого отправили на фабрику General Motors

В 1960-х годах в университетах появились лаборатории искусственного интеллекта, а 1970-х были создали микропроцессорные системы управления, которые заменили специализированные блоки управления роботов на программируемые контроллеры. Это сократило стоимость роботов примерно в три раза, так что они стали всё чаще применяться в разных отраслях промышленности. В 1982 году в IBM разработали официальный язык для программирования робототехнических систем, а спустя два года компания Adept представила первый робот Scara с электроприводом. В 1986 году роботы были впервые применены в Чернобыле для очистки радиоактивных отходов.

Двадцать первый век принёс невиданные успехи в развитии робототехники. В 2000 годы, по данным ООН, в мире использовалось уже 742 500 промышленных роботов. Невозможно перечислить все новые модели и открытия в сфере робототехники за последние 20 лет. Вот лишь некоторые из них.

В начале 2000-х многие компании представили новых гуманоидных роботов — например, Asimo от Honda и SDR-3X от Sony. Канадский космический манипулятор Canadarm2 использовался для завершения сборки МКС, а в мюнхенском Институте биохимии имени Макса Планка был создан первый в мире нейрочип. Появились первые серийно выпускаемые бытовые роботы-пылесосы (Electrolux) и первая киберсобака (Sanyo Electric). Компания Bandai представила прототип робота с возможностью распознавания человеческих лиц и голосов, ученые из Стэнфордского университета — робота STAIR (Stanford Artificial Intelligence Robot), наделенного интеллектом и способного принимать нестандартные решения, руководствуясь заложенными в него знаниями об окружающем мире. Военный робот смог распознавать и преодолевать препятствия — в NASA взяли на вооружение экзоскелет X1 Robotic Exoskeleton. Роботы стали активно использоваться в медицине при проведении хирургических операций.

Идентификация краулера

Поисковые роботы обычно идентифицируют себя для веб-сервера с помощью поля User-agent HTTP- запроса. Администраторы веб-сайтов обычно изучают журнал своих веб-серверов и используют поле агента пользователя, чтобы определить, какие поисковые роботы посещали веб-сервер и как часто. Поле пользовательского агента может включать URL-адрес, по которому администратор веб-сайта может найти дополнительную информацию о поисковом роботе. Изучение журнала веб-сервера — утомительная задача, поэтому некоторые администраторы используют инструменты для идентификации, отслеживания и проверки поисковых роботов. Спам-боты и другие вредоносные веб-сканеры вряд ли поместят идентифицирующую информацию в поле пользовательского агента или могут замаскировать свою личность в качестве браузера или другого известного поискового робота.

Поисковым роботам важно идентифицировать себя, чтобы администраторы веб-сайтов могли при необходимости связаться с владельцем. В некоторых случаях искатели могут случайно попасть в ловушку искателя или они могут перегружать веб-сервер запросами, и владельцу необходимо остановить искателя

Идентификация также полезна для администраторов, которые заинтересованы в том, чтобы знать, когда они могут ожидать, что их веб-страницы будут проиндексированы определенной поисковой машиной .

Принцип работы

Поисковый робот является браузерного типа программой. Он постоянно сканирует веб-пространство, посещая уже известные ему (проиндексированные) сайты, проходя по ссылкам с них и находя, таким образом, новые ресурсы. Обнаружив неизвестный сайт, и проведя некоторые процедуры, робот добавляет его в индекс поисковой системы.

Кроме того, поисковым роботом индексируются обновления на сайтах. Причем, периодичность обновлений фиксируется. К примеру, сайт, обновляемый раз в неделю, будет посещаться роботом с той же частотой, а информация на новостных сайтах может индексироваться уже через несколько минут.

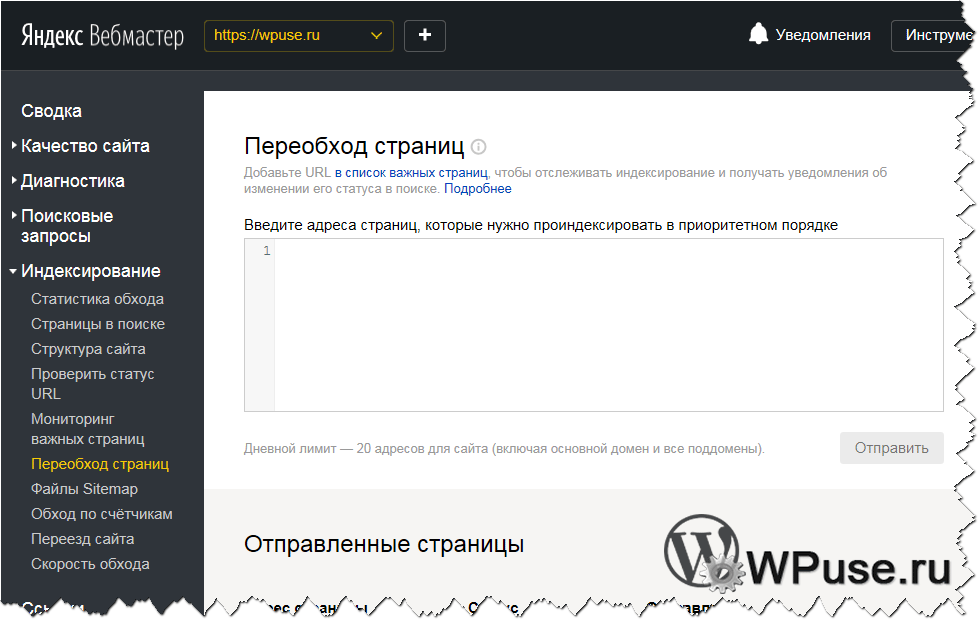

Сайтам, не обладающим внешней ссылочной массой, то есть тем из них, на которые не ведут ссылки с других ресурсов, чтобы быть проиндексированными, необходимо привлечь внимание поисковых роботов. Для этого сайт добавляется в специальную форму поисковой системы

К примеру, в панель вебмастера Яндекс, или в Центр вебмастеров Google.

Что закрывать в robots.txt?

- страницы поиска – при условии, когда вы не строите планы на их проработку и модерацию;

- корзину онлайн-магазина, страницу оформления заказа, сравнение, сортировку и фильтры товаров/услуг;

- веб-страницы для регистрации/авторизации и личный кабинет пользователей, списки желаний, профили, фиды и тому подобное;

- landing page, сформированные специально для акционных предложений, скидок, распродаж;

- системные каталоги/файлы, пустые страницы, версии для печати и языковые версии, не подлежащие оптимизации.

В общем, необходимо закрывать сведения, бесполезные для пользователей, а также ещё недоработанные страницы и дубли.

Как управлять поисковым роботом?

Очень часто приходится ограничивать доступ некоторым краулерам к определенным страницам сайта. Для этого существуют специальные правила, которые вебмастера прописывают для пауков, чтобы они их придерживались. Указываются они в файле robots.txt.

Попадая на сайт, роботы сначала сканируют информацию в файле со списком документов, запрещенных для индексации, например, личные данные зарегистрированных пользователей. Ознакомившись с правилами, краулер или уходит с сайта, или начинает индексировать ресурс.

Что прописывать в файле robots:

- разделы сайта или фрагменты контента, закрытых/открытых

для пауков; - интервалы между запросами роботов.

Команды можно адресовать как всем ботам сразу, так и каждому

по-отдельности.

Если мы откроем файл robots поисковой системы Яндекс, то

увидим:

Определим, что все это значит:

- Страница about.html закрыта от всех краулеров.

- Роботам твиттера разрешено смотреть сайты, в адресе которых содержится /images.

- Остальным поисковым паукам разрешено посещать страницы, которые заканчиваются на /images, но глубже переходить нельзя (Dissallow: /images/*).

Что такое роботы поисковики

Поисковые пауки могут именоваться еще и по-другому: роботы, веб-пауки, краулеры. Однако независимо от названия, все они заняты постоянным и непрерывным изучением содержимого виртуального пространства. Робот сохраняет список URL-адресов, документы по которым загружаются на регулярной основе. Если в процессе индексации паук находит новую ссылку, она добавляется в этот список.

Таким образом, действия краулера можно сравнить с обычным человеком за браузером. С тем лишь отличием, что мы открываем только интересные нам ссылки, а робот — все, о которых имеет информацию. Кроме того, робот, ознакомившись с содержимым проиндексированной страницы, передает данные о ней в специальном виде на сервера поисковой машины для хранения до момента запроса со стороны пользователя.

При этом каждый робот выполняет свою определенную задачу: какие-то индексируют текстовое содержимое, какие-то — графику, а третьи сохраняют контент в архиве и т.д.

Главная задача поисковых систем — создание алгоритма, который позволит получать информацию о контенте быстро и наиболее полно, ведь даже у гигантов поиска нет возможностей обеспечить всеобъемлющий процесс сканирования. Поэтому каждая компания предлагает роботам уникальные математические формулы, повинуясь которым бот и выбирает страницу для посещения на следующем шаге. Это, вкупе с алгоритмами ранжирования, является одним из важнейших критериев по которым пользователи выбирают поисковую систему: где информация о сайтах более полная, свежая и полезная.