Что такое дипфейк?

Deepfake (от англ. deep learning — «глубокое обучение» и fake — «фальшивый») — реалистичная манипуляция аудио- и видеоматериалами с помощью искусственного интеллекта. Эта технология заставляет человека говорить то, чего он не произносил, и делать то, чего он никогда не совершал.

Технология Deepfake уходит корнями в далёкие девяностые. В то время подобными инструментами обладали лишь эксперты по спецэффектам в киноиндустрии. Впоследствии технология была доработана в интернет-сообществе, и программное обеспечение для создания дипфейков появилось в открытом доступе

В последнее время технология Deepfake привлекает большое внимание из-за её использования в финансовых махинациях, розыгрышах и фальшивых новостях (fake news)

Deepfake применяет возможности искусственного интеллекта для синтеза человеческого изображения: объединяет несколько снимков, на которых человек запечатлён с разных ракурсов и с разным выражением лица, и делает из них видеопоток. Анализируя фотографии, специальный алгоритм обучается тому, как выглядит и может двигаться человек. При этом работают две нейросети. Первая из них генерирует изображения, а вторая отвечает за поиск отличий между ними и настоящими образцами. В случае если вторая нейросеть обнаруживает подделку, изображение отправляется обратно первой для усовершенствования.

Deepfake работает при помощи открытых алгоритмов машинного обучения и библиотек, что позволяет достичь высшего качества контента. Нейросеть получает изображения из библиотеки и обучается при помощи роликов на видеохостингах. Искусственный интеллект тем временем сопоставляет фрагменты исходных портретов с тем, что есть на видео, и в итоге получается правдоподобный материал.

Дипфейк может создать любой человек — вопрос лишь в качестве контента

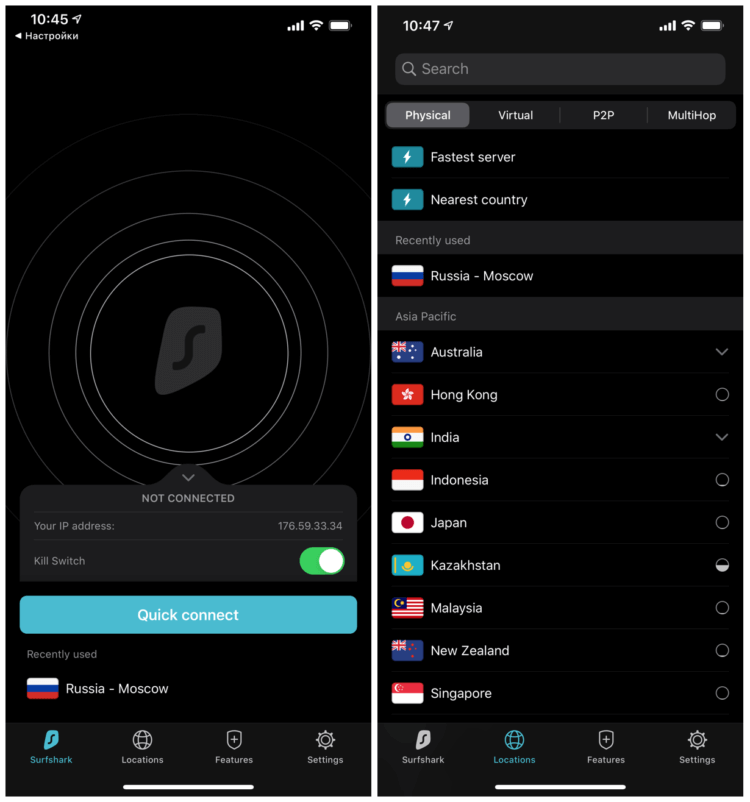

Самый простой способ создать дипфейк — использовать какое-нибудь простое приложение для Android или iOS. Выбор богатый, а вот возможности — ограниченные. Но ради развлечения можно попробовать.

Например, приложение Doublicat. Вы делаете селфи и помещаете фото на заготовку. Приложение само подбирает выражение лица.

Похожий результат даёт FaceApp — приложение от российских разработчиков из Wireless Lab, благодаря которому ленты всех соцсетей были забиты состаренными фотографиями людей. В нём можно не только постареть, но и добавить бороду или сменить причёску.

https://youtube.com/watch?v=cIOojN25sFc

Для работы обеих программ требуется мощная видеокарта и много свободного времени — замена лица в видео происходит невероятно медленно. Для достижения приемлемого результата также требуется практика — нейросеть придётся долго обучать и тонко настраивать.

Можно ли распознать deepfake?

Видео с применением deepfake выглядят убедительно только в течение пары-тройки секунд, но они (во всяком случае, пока) далеки от того, чтобы обмануть пользователей.

Эффект постоянно открытых глаз связан с недостатками процесса создания таких роликов. Дело в том, что среди картинок, по которым обычно учится нейросеть, не так много (на самом деле их нет вообще) фотографий с закрытыми глазами. Пользователи вряд ли хранят или выкладывают в сеть неудачные селфи, на которых они моргают.

Адиль Жалилов отмечает, что в перспективе распознавать deep fakes можно будет путём анализа движения глаз и амплитуды моргания.

«Предполагаю, что найдутся и другие методы распознавания поддельных видео

И очень важно, чтобы эти методы были простыми и прикладными, доступными для общества. Также важно всем государствам активно развивать и поддерживать фактчекинг, специализирующийся на борьбе с дезинформацией, а также медиаграмотность, куда включать обучение всего населения в том числе по распознаванию поддельных изображений и видео», – говорит Жалилов

Что такое Big data, и почему вам стоит беспокоиться о безопасности личных данных

Чтобы распознать deepfake, учёные из Университета Олбани провели эксперимент, в котором выявили, что в среднем люди моргают 17 раз в минуту. Эта цифра увеличивается до 26 раз во время разговора, и падает до 4,5 раз во время чтения. Эти же учёные предложили свой метод распознавания фейковых видеороликов, объединив две нейронные сети, для того чтобы более эффективно распознавать ненастоящие лица. Как выяснилось, нейронные сети часто упускают спонтанные и непроизвольные физиологические действия. Например, дыхание во время речи или движение глаз.

Профессор отмечает, что стандарты проверки доказательств deep fake должны развиваться параллельно улучшению поддельных видео, иначе однажды мы вообще не сможем доверять видеоконтенту.

Что такое технология Deepfake?

Deepfakes относятся к манипулируемому визуальному контенту, генерируемому сложным искусственным интеллектом, который дает сфабрикованные изображения и звуки, которые кажутся реальными. В большинстве случаев, человек в существующем видео или изображении заменяется на чье-то подобие.

Deepfakes создаются с использованием моделей глубокого обучения — подкласса методов машинного обучения, основанных на искусственных нейронных сетях с репрезентативным обучением. Он включает в себя обучение генеративных архитектур нейронных сетей, таких как генеративные состязательные сети или автоэнкодеры.

Хотя трудно создать хороший deepfake на обычном компьютере, есть много инструментов, доступных в интернете, чтобы помочь людям сделать достойные deepfakes. Технология все еще находится в зачаточном состоянии, поэтому не ожидайте идеального результата.

Мы тщательно собрали несколько хороших deepfake приложений и инструментов, которые не требуют высокого класса рабочего стола с мощными графическими картами (за исключением одного или двух). Вы можете использовать их как в исследовательских целях, так и просто для развлечения, но не нарушайте чью-либо частную жизнь.

Подделки речи приносят мошенникам миллионы

Для полноты иллюзии в роликах Ctrl Shift Face знаменитых актеров переозвучивают живые люди. Кстати, именно это создатель-создательница канала считает причиной, по которой ролик про Терминатора со Сталлоне не получился: «У меня не вышло отредактировать бесшовно, поэтому музыка и звуки на заднем плане заметно не совпадают».

Возможно, если бы Ctrl Shift Face использовал программы для синтеза речи, результат получился точнее. Тем более что в интернете можно найти сотни и сотни часов с голосами голливудских звезд, из которых можно выделить любые нужные слова.

Сервисы синтеза и копирования речи есть практически у каждой крупной IT-компании. Они объясняют необходимость развития этой технологии по-разному и одинаково неубедительно. Google Ассистент, например, сможет сам звонить в рестораны и человеческим голосом с реалистичными паузами заказывать столик в ресторане. А приложение китайской компании Baidu, которое воссоздает речь человека, послушав его всего одну минуту, пригодится пациентам, лишившимся голоса, и мамам, которые смогут озвучивать аудиокниги своим голосом.

fake

Google Ассистент сможет сам звонить в рестораны и человеческим голосом с реалистичными паузами заказывать столик в ресторане

Фото: Global Look Press/ZUMA

Естественно, возникают опасения, что этой технологией будут пользоваться мошенники. И недавно по анонимным Telegram-каналам со ссылкой на анонимные источники в правоохранительных органах разошлась страшилка. Будто бы мошенники взламывают пользователей мессенджеров, скачивают их голосовые сообщения, собирают из этих сообщений новые и рассылают их родным с просьбой прислать денег.

Помимо того что это еще один аргумент не пользоваться голосовыми сообщениями, это вполне рабочая мошенническая схема.

Как рассказывал специалист по информационной безопасности компании Symantec, в их практике было три случая, когда людей обманули с помощью синтезированного голоса. Причем во всех трех случаях жертвами стали топ-менеджеры крупных компаний, а сумма ущерба насчитывает миллионы долларов.

Тем, у кого нет миллионов долларов, пока, скорее всего, беспокоиться не стоит. По словам звукорежиссера Романа Бакши, который специализируется на обработке голосов, чтобы сделать убедительную подделку, нужно очень много образцов речи человека. «В свое время мне пришлось прослушать около пяти часов разговоров, чтобы синтезировать одно слово», — рассказал он.

Дипфейк – это

Процесс создания дипфейка, не углубляясь в сложные технические подробности, выглядит так: один алгоритм генеративно-состязательной нейросети изучает фото и видео с определенным человеком и создает изображение, буквально «состязаясь» со вторым алгоритмом, пока тот не начнет путать копию и оригинал. Таким образом изображение одного человека подобием маски накладывается на другого.

AP

AP

«Если вы хотите попросить Обаму сказать то, что он никогда не говорил, тогда вы должны направить свое программное обеспечение на изучение связей между конкретными словами и формой рта Обамы, когда он их произносит. Чтобы прикрепить его лицо к движущемуся телу другого человека, вы должны направить ПО на изучение связей между лицом и телом», — пишет издание.

Чтобы сделать мультимедиа более реалистичными, можно заставить программное обеспечение конкурировать с собственной копией – одна версия генерирует дипфейки, а другая пытается их распознать.

Примеры бесплатных дипфейк-приложений и инструментов

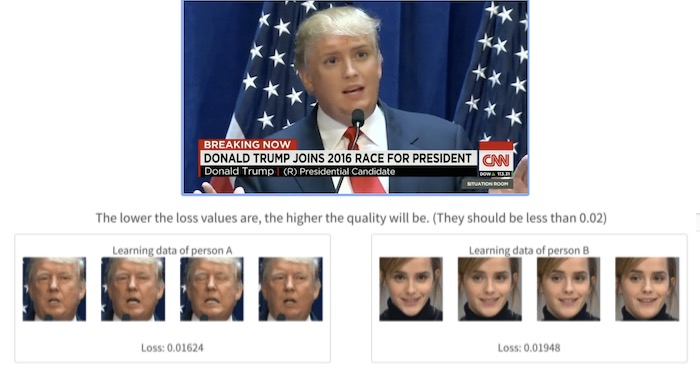

DeepFaceLab

Рисунок 1. Обработка изображения для создания дипфейка в ПО DeepFaceLab

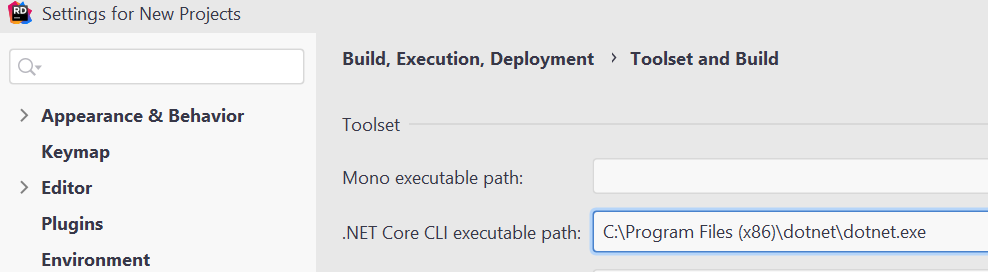

DeepFaceLab распространяется в виде набора пакетных файлов для ОС Windows. Минимальные системные требования — 2 ГБ ОЗУ и место для файла подкачки, а также OpenCL-совместимая видеокарта с объёмом ОЗУ не менее 256 МБ.

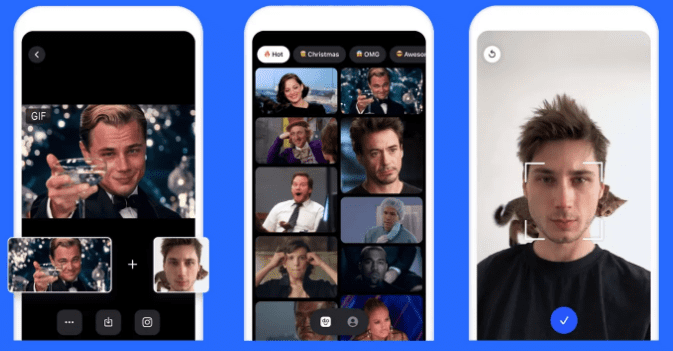

Doublicat

Рисунок 2. Обработка изображения для создания GIF-дипфейка в Doublicat

Для создания изображения нужно сделать селфи, а затем выбрать какой-либо из знаменитых GIF-мемов и вставить туда своё лицо.

В начале января приложение Doublicat стало вирусным. О нём написали десятки западных изданий.

Zao

Рисунок 3. Обработка изображения для создания видео-дипфейка в Zao

Многие пользователи сочли, что приложение может оказаться небезопасным, поскольку в политике конфиденциальности указано, что компания-разработчик Momo вправе применять сгенерированные видеоролики в собственных целях (т.е. ей принадлежит весь созданный программой контент).

Deepfake как угроза для информационной безопасности бизнеса

Помимо политических информационных войн Deepfake создаёт и риски в области информационной безопасности корпоративного сектора. Дипфейки оказались неплохим инструментом в руках мошенников.

Дипфейки имеют возможность «перегружать» подобные операции. Например, сотрудник компании получает электронное письмо от генерального директора с просьбой принять некоторые финансовые меры, затем ему приходит текстовое послание с мобильного номера того же топ-менеджера, а потом — и аудиосообщение, где голос генерального директора называет работника по имени и ссылается на предыдущие разговоры с ним. Скорее всего, сотрудник не задумается о том, дипфейк это или нет.

Zao

Платформа: | Цена: бесплатно

Технология глубокого подделки Zao позволяет вам модулировать голоса знаменитостей и накладывать свое лицо на тело актера в сцене.

Просто нажмите на одну фотографию и попробуйте тысячи модных причесок, одежды и макияжа. Приложение предоставляет вам множество видеоклипов, нарядов и буквально неограниченные возможности для изучения.

В 2019 году Zao за короткое время приобрел значительную популярность, позволив пользователям обмениваться лицами с любимыми актерами в коротких клипах из телепередач и фильмов. За месяц он стал самым загружаемым бесплатным приложением в Китае. С ростом популярности, его разработчики также столкнулись с критикой политики конфиденциальности приложения.

Это займет всего несколько секунд, чтобы поменять ваше лицо, но так как алгоритм в основном обучен на китайских лицах, это может выглядеть не так естественно, как вы ожидаете.

Тем не менее, все эти инструменты демонстрируют, как быстро развивался базовый ИИ: то, что раньше требовало тысячи картинок, чтобы сделать достаточно убедительное глубокое поддельное видео, теперь требует только одного изображения и дает лучшие результаты.

Киноиндустрия защищает поддельное порно

Deepfake, как, впрочем, и вообще всё на свете, от спинеров до гироскутеров, поглотила порноиндустрия. В интернете легко найти ролики с моделями, которых нейросети превращают в кинозвезд. И кинозвезды с этим ничего сделать не могут.

Скарлетт Йоханссон и ее команда пытались убрать из интернета поддельное видео с ее участием. И у них ничего не вышло. Проблема в том, что в разных странах разное законодательство в вопросах интернета. Поэтому, даже если добиться удаления роликов из поисковиков в одной стране, во всех остальных странах они будут доступны. «Известия» уже писали о том, насколько сложный труд — добиться права на забвение в разных странах.

Скарлетт Йоханссон, актриса

Актриса не получила поддержки не только со стороны поисковиков, но и от крупнейших киностудий.

Единственная пока что попытка запретить deepfake-видео была предпринята в мае прошлого года в Нью-Йорке. Тогда на рассмотрение в Ассамблее штата был подан законопроект, который, в частности, запрещал использование цифровой копии живого или мертвого человека без ее или его согласия или согласия потомков.

Против законопроекта выступила Американская ассоциация кинокомпаний, в которую входят The Walt Disney Company, Sony Pictures, Paramount Pictures, 20th Century Fox, Universal Studios Warner Bros и Netflix.

fake

Лоуренс Оливье в фильме «Небесный капитан и мир будущего» 2004 года

Фото: kinopoisk.ru/Парадиз

Кинематографисты высказались в том ключе, что ограничения, которые вводит законопроект, сделают практически невозможным создание байопиков об актерах, музыкантах и атлетах. При этом компании признали, что deepfake — проблема. Но решать ее в ущерб свободе слова и творчества они не согласны.

Больше того, голливудские компании сами заинтересованы в технологии воссоздания облика известных актеров. Первый раз в большом коммерческом кино ее использовали в 2004 году. Тогда в фильме «Небесный капитан и мир будущего» появился Лоуренс Оливье, умерший в 1989-м. Его лицо не слишком детально воссоздали и анимировали по старым фотографиям. В 2016 году к жизни вернули Питера Кушинга для небольшой роли в фильме «Изгой-один. Звездные войны: Истории». Кушинг умер в 1994-м.

Нейросети регулярно используют для омоложения актеров в фильмах про супергероев Марвел — Майкла Дугласа, Роберта Дауни мл., Сэмюэля Л. Джексона. Делали это и с 68-летним Арнольдом Шварценеггером в пятом «Терминаторе», и с 54-летним Джонни Деппом в пятых же «Пиратах Карибского моря».

При такой заинтересованности киноиндустрии можно предположить, что технология изменения лиц будет развиваться, и быстро. А законотворцам, которые пытаются ее запретить, придется нелегко. В июне 2018 года их законопроект был передан на рассмотрение в комитет сената. И с тех пор его судьба неизвестна.

Что такое deepfake?

Искусственный интеллект deepfake использует синтез человеческого изображения – объединяет несколько картинок, на которых человек запечатлен с разных ракурсов и с разным выражением лица, и делает из них видео. Анализируя фотографии, специальный алгоритм «учится» тому, как выглядит и может двигаться человек.

Работают две нейросети. Первая генерирует образцы изображения, а вторая отвечает за то, чтобы отличать настоящие образцы от поддельных. Технологию можно сравнить с работой двух фальшивомонетчиков, один из которых подделывает купюры, а второй пытается отличить эти подделки от оригиналов. В случае если второй обнаруживает подделку, изображение отсылается первому, который улучшает свою работу, предлагая более реалистичную подделку.

Сервисы deepfake работают при помощи открытых алгоритмов машинного обучения и библиотек, за счёт чего нейросеть может не только обучиться, но и достичь «почти человеческого» качества. Нейросеть получает изображения из библиотеки и «учится» при помощи роликов на том же YouTube. Искусственный интеллект тем временем сопоставляет фрагменты исходных портретов с тем, что есть на видео, и в итоге мы получаем максимально правдоподобную картинку.

Поддельные видеоролики стали появляться в 2017-м году, когда один из пользователей социального сервиса Reddit с ником Deepfakes разместил у себя на страничке видео для взрослых, где вместо настоящего лица актрисы было «подрисовано» лицо исполнительницы роли Чудо-женщины Галь Гадот. Позже подобная технология также была использована для ролика, где экс-президент США Барак Обама нецензурно выражался и оскорблял Дональда Трампа. Лицо экс-президента просто наложили на лицо актёра Джордана Пила. Получилось правдоподобно.

Обнаруживать дипфейки всё сложнее — для этой цели приходится тренировать другие нейросети

Вопросами распознавания дипфейков занимаются IT-гиганты, но пока эффективных инструментов нет — процент ошибок всё ещё очень высокий. Эксперты считают, что в ближайшее время технология разовьётся до уровня, когда отличить фейк от оригинала станет невозможно. Единственный выход — развитие других нейросетей, которые будут бороться с ИИ, создающим дипфейки.

Twitter, Reddit и PornHub тоже столкнулись с проблемой фейкового контента и теперь пытаются найти решение. Пока получается не очень хорошо, так что единственная надежда — на здравый смысл и наблюдательность пользователей. Несмотря на то, что системы совершенствуются, в результатах работы нейросетей все ещё остаются артефакты, которые помогают людям «на глаз» определять фейковость видео. Это можно назвать проблесками в матрице — на их обнаружение и натаскиваются системы, которые должны научиться находить фейковые записи.

Другая команда учёных придумала необычный подход. Разработчики создали среду, которая предсказывает, какие слова с наибольшей вероятностью появятся в предложении. По сути, их алгоритм пишет собственный фейковый текст и использует его в качестве ориентира для нахождения искусственно созданного контента. Однако процент правильного срабатывания системы неизвестен.

При этом для создания поддельной аудиозаписи нужен небольшой набор данных. Коммерческие системы способны собрать похожий на оригинал голос на основе нескольких минут исходного материала. Сложные модели типа Deep Voice от Baidu копируют голос с образца продолжительностью менее 4 секунд.

Казалось бы, что проще — запретить технологию, из-за которой появляются дипфейки. Проблема в том, что модель машинного обучения, позволяющая подделывать контент, одновременно приносит огромную пользу человечеству: помогает усовершенствовать медицинскую диагностику, улучшает обучение беспилотных систем. И параллельно даёт возможности для обмана, который трудно разоблачить.

Мошенники не дремлют

«Дипфейки могут использоваться как мощный дискредитирующий инструмент, средство разжигания ненависти между социальными и национальными группами. А в 2019 году технологию даже использовали для финансовых махинаций», — говорит Масленников. Руководителю английской энергетической компании позвонил мошенник и попросил сделать срочный денежный перевод. Он точно воспроизвел чужой голос и интонацию, поэтому его просьба была выполнена. Недавно по анонимным telegram–каналам прошла информация, что мошенники уже начали собирать аудиосообщения пользователей, чтобы в будущем создавать записи с просьбой одолжить деньги.

Дипфейки пригодятся и маркетологам: можно заставить рекламировать товар тех, кто никогда бы не согласился на это. «Нелегальные букмекерские конторы могут снять видео с любым человеком и приделать голову блогера. Люди с невысокой технической грамотностью запросто попадутся на такой трюк», — говорит Антон Круглов, операционный директор агентства BlackLight Creative Communications.

Очевидно, что для предотвращения подобных преступлений необходимо ПО, отличающее истину от подделки. «Так, совместно с Microsoft, MIT и Калифорнийским университетом объявил Deepfake Detection Challenge — состязание в способах выявления фейкового контента. Facebook готов инвестировать $10 млн в борьбу с дипфейками», — говорит Масленников.

Эксперты считают дипфейки одной из главных угроз нашего времени, политики с ними согласны

Уже сейчас дипфейки затрагивают различные области жизни. Вот несколько неприятных примеров использования нейросетей против репутации известных людей.

Дипфейки активно применяются и в нечестной политической конкуренции. В 2019 году появилось видео со спикером палаты представителей конгресса США Нэнси Пелоси (Nancy Pelosi). В нём она плохо выговаривала слова, так что у зрителей сложилось впечатление, что политик находится в состоянии алкогольного опьянения. В США был громкий скандал. Лишь спустя некоторое время специалистам удалось доказать, что речь Пелоси была переделана нейросетью.

Власти в разных странах прекрасно осведомлены обо всех опасностях дипфейков. Например, в Китае с 1 января 2020 года публикация любой заведомо ложно информации, в том числе созданной с помощью нейросетей, считается уголовным преступлением.

Дипфейк в действии

Один из самых популярных примеров дипфейка, который мы уже упоминали выше, ‒ это «видеообращение» бывшего американского лидера Барака Обамы, в котором он называет Дональда Трампа «засранцем». Разумеется, что ничего подобного Обама не говорил, а ролик на самом деле был создан с помощью программы Fakeapp и графического редактора Adobe After Effects.

Опубликовали его в 2018 году американский режиссер Джордан Пил и издание BuzzFeed с целью показать, как в будущем будут выглядеть фейковые новости.

https://youtube.com/watch?v=cQ54GDm1eL0

Учитывая то, что миссия «Аполлон-11» завершилась успехом, подготовленная заранее траурная речь Никсону не понадобилась. Возвращаясь к дипфейкам, отметим, что президент все-таки «сообщил» о гибели экипажа. Соответствующий фейковый видеоролик был представлен на Международном кинофестивале в Амстердаме.

Для создания этого видео сотрудникам Центра дополненной реальности Массачусетского технологического института сперва пришлось визуализировать речь Никсона, а затем воспроизвести его голос. К слову, для этого команда сотрудничала с украинским стартапом Respeecher, который с помощью нейросетей воссоздает голос любого человека.

А вот так выглядит «превращение» американской актрисы Дженнифер Лоуренс в актера Стива Бушеми.

Следующий дипфейк обязателен к просмотру поклонникам Николаса Кейджа. На этом ролике лицо актера появляется в кадрах из различных фильмов.

Американская телеведущая Опра Уинфри с лицом боксера Майка Тайсона:

Или появление Джокера в фильме «Истории рыцаря»:

«Игра престолов» тоже не осталась в стороне. После выхода последнего сезона сериала появился ролик, в котором один из героев шоу Джон Сноу просит прощения за финал саги.

А в этом дипфейке можно посмотреть на Киану Ривза в роли Фореста Гампа (на самом деле главного героя одноименного фильма сыграл американский актер Том Хэнкс):

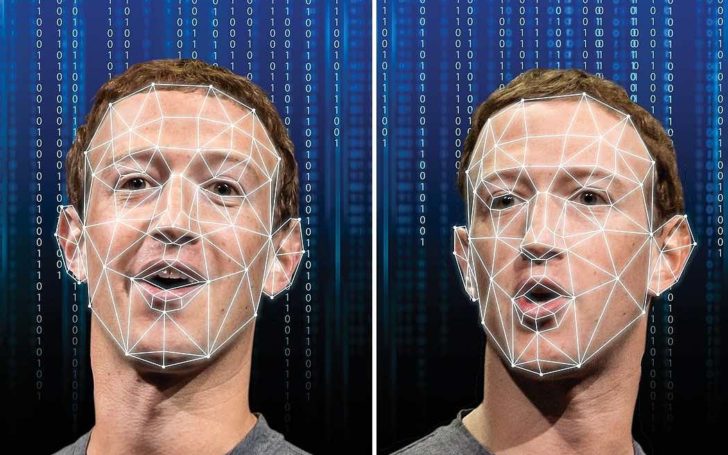

В июне этого года появилось фейковое видео с владельцем Facebook Марком Цукербергом, в котором он говорит о том, что «один человек владеет ворованными данными о миллиардах людей, все их тайны, их жизнь и будущее».

И наконец видео, которое мы анонсировали еще в самом начале: «объединение» с помощью нейросети Трампа и Путина. Создателем дипфейка является моушен-дизайнер и художник из Берлина Александр Курт.

Что такое дипфейк и как работает

Дипфейк — видео, созданное с помощью искусственного интеллекта. Если упрощённо, нейросеть по пикселям собирает ролик на основе готовых изображений. Например, может изучить тысячи фотографий Дэвида Бекхэма и выпустить видео, на котором спортсмен призывает людей бороться с малярией.

Дипфейк с Дэвидом Бекхэмом. Футболист на пяти языках призывает подписать петицию против малярии

Другой вариант работы — искусственный интеллект накладывает одного персонажа на другого и получается комбо: Джим Керри в роли злодея из фильма «Сияние» или Бред Питт в образе терминатора.

Нейросеть показала, как выглядел бы Джим Керри в фильме «Сияние». Смотреть пример целиком

Бред Питт в роли терминатора — очередная фантазия дипфейка